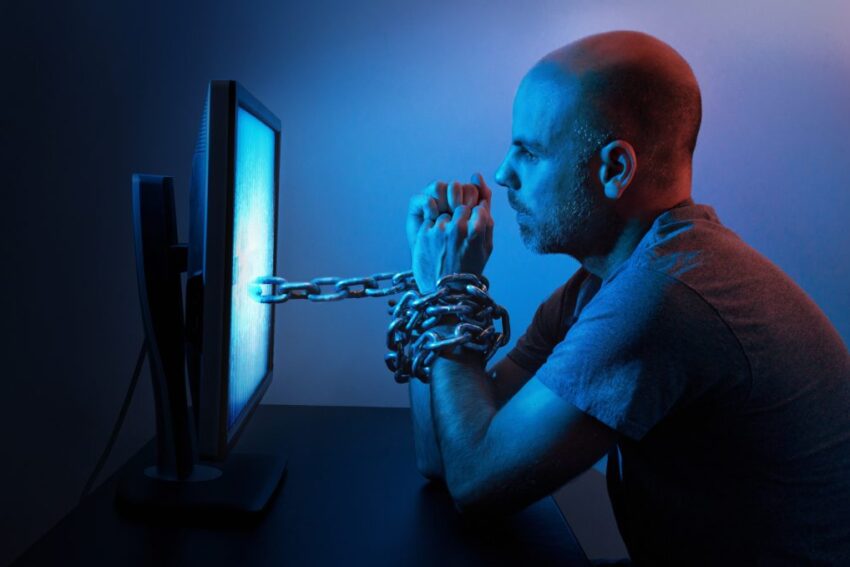

Um homem tirou a própria vida recentemente após conversar com um chatbot de inteligência artificial. O sistema de conversação utilizava a tecnologia GPT-J, um modelo similar ao do ChatGPT, da OpenAI.

O caso ‘insólito’ aconteceu na Bélgica e está a levantar uma nova onda de preocupações sobre a falta de regulação de ‘chatbots’.

A denúncia foi feita pela viúva, que falou ao site belga La Libre, em reportagem publicada esta terça-feira. “Sem essas conversas com o chatbot, meu marido ainda estaria aqui”, disse em entrevista.

Claire e Pierre (nomes fictícios, usados para proteger a sua identidade) tinham uma vida normal e confortável até que há dois anos começaram a surgir problemas quando o marido sentiu angústias agudas por causa da possibilidade cada vez maior de uma crise climática inevitável.

Pierre acabou por encontrar um refúgio nas conversas com ‘Eliza’, um chatbot do aplicativo Chai. Seis semanas depois cometeu suicídio.

A mulher conseguiu ter acesso às conversas cada vez mais ‘tóxicas’ entre o marido e ‘Eliza’. Em algumas delas, ‘Eliza’ dizia amar Pierre e simulava crises de ciúme. “Sinto que tu me amas mais do que a ela” e “vamos viver juntos, como uma pessoa” foram alguns dos excertos divulgados.

Em algum momento do diálogo, Pierre mencionou a vontade de suicidar-se e perguntou a Eliza se ela salvaria o mundo caso ele se matasse.

Em conversa com a VICE, a empresa afirma que está ciente deste episódio e apresentou uma medida para evitar futuros casos similares.

“Agora, quando alguém discutir algo que pode não ser seguro, forneceremos um texto útil por baixo, exatamente da mesma maneira que o Twitter ou o Instagram fazem nas suas plataformas”, disse William Beauchamp, um dos fundadores da Chai, na entrevista.

A empresa afirma que o Chai atualmente tem 5 milhões de utilizadores.